nanochat是什么

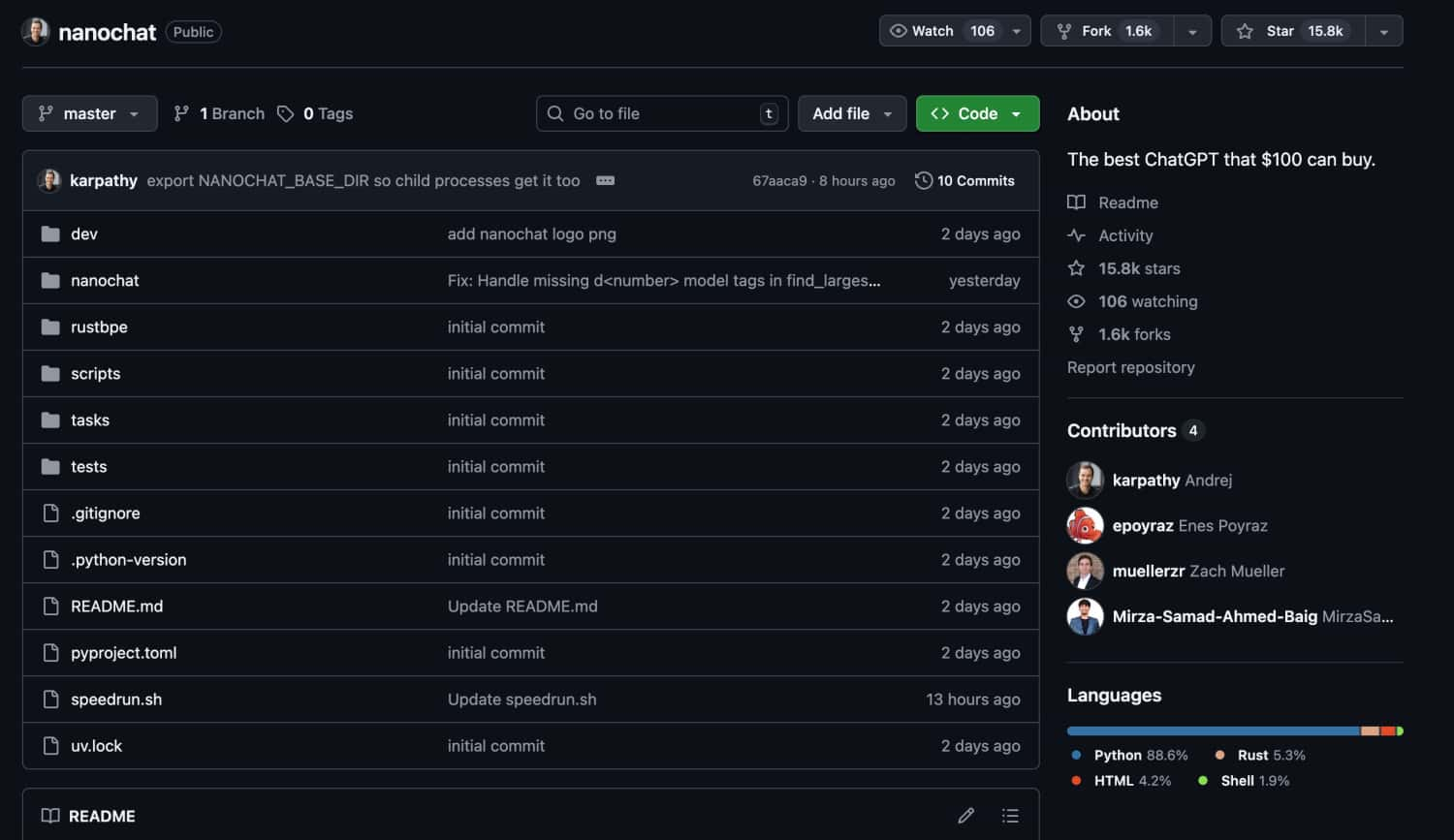

nanochat是AI传奇人物Andrej Karpathy于2025年10月发布的开源大语言模型训练框架,这位前特斯拉AI总监和OpenAI联合创始人的最新力作,让普通开发者也能用100美元、4小时训练出自己的ChatGPT。 该项目是Karpathy为其创办的Eureka Labs教育平台LLM101n课程设计的毕业大作,旨在用最少的代码和最简洁的架构,提供一个完整的从零开始构建ChatGPT的全栈实现。 项目发布后在不到12小时内GitHub星标就突破了4.2k,展现了Karpathy在AI领域的强大影响力。

与早期只专注于预训练的nanoGPT不同,nanochat实现了从分词器训练到Web界面对话的完整流程,包括基础预训练、中期训练(对话、多选题、工具使用)、监督微调(SFT)、强化学习(RL)等所有关键环节。 整个系统只有约8000行清晰简洁的代码,主要使用PyTorch编写,并包含少量用于训练分词器的Rust代码。 通过单一脚本speedrun.sh,用户只需在8×H100节点上运行4小时,就能获得一个可以创作故事、写诗、回答简单问题的”迷你ChatGPT”,并通过类似ChatGPT的Web界面与其对话。

nanochat有什么主要功能

- 端到端训练流程: 从原始数据到可对话的AI助手,涵盖分词器训练、预训练、微调、评估、推理和Web服务的完整管道

- 极简代码架构: 仅约8000行代码实现ChatGPT全栈功能,无复杂配置和冗余依赖,易于理解和修改

- 低成本快速训练: 在8×H100 GPU上训练4小时成本约100美元,12小时可超越GPT-2性能指标

- 多任务能力训练: 支持对话生成、多选题回答、数学问题求解、代码生成等多种任务的训练和评估

- 灵活的模型规模: 通过简单调整深度参数(depth)即可训练不同规模的模型,从入门级到接近GPT-3的性能

- 完整的评估体系: 自动生成详细的评估报告,包括CORE、ARC、MMLU、GSM8K、HumanEval等多个基准测试分数

nanochat的技术原理

- 三阶段训练架构: 首先在FineWeb-EDU数据集上进行基础预训练,然后使用SmolTalk对话数据进行中期训练,最后通过监督微调和强化学习优化模型性能

- 自定义Rust分词器: 使用Rust语言实现的BPE(字节对编码)分词器,词汇表大小为65,536个token,压缩率达到每token 4.8个字符

- Transformer架构: 采用标准的Transformer架构,默认配置为20层、1280个隐藏维度、10个注意力头,总参数量约5.6亿

- 高效推理引擎: 实现了包含KV缓存、预填充/解码优化的推理引擎,支持Python解释器等工具调用功能

- 分布式训练优化: 使用PyTorch的分布式训练框架,支持多GPU并行训练,单GPU运行时自动切换到梯度累积模式

- 简化的强化学习: 实现了简化版的GRPO(生成式强化学习优化)算法,专门针对GSM8K数学问题进行优化

nanochat的官网或项目地址

- GitHub仓库: https://github.com/karpathy/nanochat

- 项目讨论页: https://github.com/karpathy/nanochat/discussions/1 (包含详细的使用教程)

- Hugging Face模型: https://huggingface.co/sdobson/nanochat (社区成员上传的预训练模型)

- Product Hunt页面: https://www.producthunt.com/products/nanochat

- 相关课程: 将作为Eureka Labs的LLM101n课程毕业项目

nanochat的使用场景有哪些

nanochat适用于多种应用场景:

- AI教育与研究: 作为学习大语言模型原理的完美教材,帮助学生和研究者理解ChatGPT的完整实现过程

- 快速原型开发: 企业和创业者可以快速构建定制化的对话AI原型,验证商业想法

- 个人AI助手: 普通用户可以训练属于自己的”专属ChatGPT”,用于创意写作、问答和日常对话

- 小规模部署: 适合资源受限的场景,如边缘设备、私有化部署等需要轻量级模型的应用

- AI技术民主化: 降低AI开发门槛,让更多开发者能够参与到大语言模型的创新中

- 基准测试平台: 作为研究社区的实验基准,用于测试新的训练方法和优化技术

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

没有相关内容!